Mastertools im Online-Marketing – Wie Daten Marketer schlau machen

Andreas Volz, 27. Oktober 2014Daten werden der entscheidende ökonomische Produktionsfaktor der Zukunft sein und traditionelle Wertschöpfungsketten ablösen. Wir erleben eine Transformation in der Daten und vor allem das in den Daten verborgene Wissen, dem Smart Knowledge, den entscheidenden Wettbewerbsvorteil darstellen. Mastertools in Form von Frameworks, prozessübergreifenden Schnittstellen und Applikationen sind Voraussetzung für diese ganzheitliche Wissensermittlung.

Der entscheidende Mehrwert prozessübergreifender Analysen liegt im Data Meshing, der sinnvollen Kombination verschiedener Datenquellen, wie zum Beispiel der Verknüpfung unterschiedlicher Marketingkanäle, Usercharakteristika aus historischen Daten und Real-Time-Daten sogenannter Data Streams sowie aus Social-Media-Informationen und vielen weiteren Quellen. Ein Eldorado für die Erzielung von Smart Knowledge.

Was versteht man eigentlich unter Smart Knowledge oder Smart Data?

Unter Smart Data oder Smart Knowledge kann ganz allgemein der sinnvolle und vernünftige Umgang mit den Inhalten von Big Data Stores – den unterschiedlichen vielfältig zugänglichen Datenquellen (zum Beispiel Userdaten, Userpräferenzdaten, CRM, betriebliche Daten, Social-Media-Daten, Daten aus dem Internet der Dinge, Sensordaten etc.) – verstanden werden. Fachlich spricht man von Knowledge Discovery in Databases. Der Schwerpunkt liegt auf der Entdeckung (Discovery) relevanter Zusammenhänge in Datenbanken oder zwischen diversen Datenquellen. Ziel ist es, nützliches Wissen zu generieren, das dann zu informierten Entscheidungen, verbesserten Geschäftsmodellen und damit zum entscheidenden Wettbewerbsvorteil werden kann. Hieraus resultiert auch der Begriff "Competing on Analytics".

Die Generierung von Smart Knowledge ist gar nicht so einfach: Schließlich erfordern die vorbereitenden Schritte vor der eigentlichen Analyse ca. 80 Prozent des Gesamtaufwands. Zum Beispiel müssen die Daten verknüpft, an unterschiedliche Input-, Algorithmen- und Datenformate angepasst werden. Unterschiedliche Datenquellen und Marketingkanäle können unterschiedliche Formate haben, geeignete Zuordnungsschlüssel müssen gefunden und angepasst werden. Um geeignete Zielgruppencluster zu bilden, müssen die Daten oftmals mit trigonometrischen oder noch rechenintensiveren Funktionen behandelt werden. Kontrollgruppen müssen erzeugt, von Zielgruppen abgegrenzt und gelabelt werden, um zum Beispiel Käufer von Nichtkäufern unterscheiden zu können, etc.

Zur Generierung von Smart Knowledge muss also ein umfangreicher Prozess angestoßen werden, der die Daten aus den Big Data Stores sinnvoll und effizient transformiert, unterschiedliche Datenquellen verknüpft und für die Analyse und die Modellierung vorbereitet. Dann erst können Machine Learning und Visualisierungstools zur Akquisition des nützlichen Wissens zum Einsatz kommen.

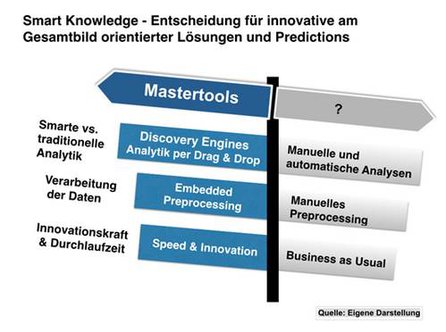

Smart Knowledge Akquisition mithilfe von Mastertools

Ein Anwendungsbereich von Mastertools ist der intelligente Aufbau einer sogenannten Discovery Engine, die alle oben genannten manuellen Preprocessing- und Predictionworkflows in einem Tool integriert.

Wege zum Smart Knowledge; Grafik: Andreas Volz, datenstrategien

Wege zum Smart Knowledge; Grafik: Andreas Volz, datenstrategien

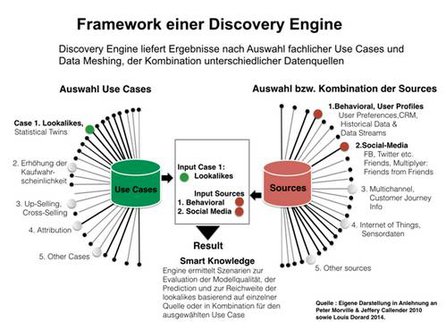

Der Einsatzbereich der Engine reicht von der Entdeckung interessanter und relevanter Zusammenhänge in den unterschiedlichsten Datenquellen bis hin zur gezielten und kontrollierten Steuerung der unterschiedlichsten Marketingmaßnahmen. Die Discovery Engine ermittelt im Hintergrund die erforderlichen aufwendigen und zeitintensiven Arbeitsschritte und gibt sie in Form von Strategievorschlägen zurück. Die Engine berücksichtigt somit das Spannungsmoment zwischen dem, was Marketingverantwortliche suchen oder erklären wollen, und der Interessantheit bzw. der Relevanz des explorierten Wissens. Sehr oft liegt nämlich die angemessene Antwort nicht im Zentrum der Fragestellung, sondern eher am Rand des eingeschlagenen Suchkorridors. Das ist der eigentliche Sinn von Discovery – das nicht so offensichtliche, das in den Daten verborgene Wissen zu entdecken und darauf aufbauend geeignete Prozesse anzustoßen, an die vorher nicht zu denken war.

Die nachfolgende Grafik verdeutlicht den grundsätzlichen Aufbau einer Discovery Engine:

Grafik: Andreas Volz, datenstrategien

Grafik: Andreas Volz, datenstrategien

Anwendungsszenario: Mehrwert durch Analysen basierend auf mehreren Datenquellen

Nachfolgend wird die Funktionsweise einer Discovery Engine anhand eines fiktiven Anwendungsszenarios dargestellt.

Ein Marketer will wissen, wie er die Reichweite seiner Kampagnen erhöhen kann, indem er zu seinen Bestandskunden Neukunden hinzugewinnt. Er kann dabei auf Behavioral-Daten also historische Nutzerprofile und auf eine Datenbank, in der Informationen über die Social-Media-Nutzung seiner Kunden enthalten sind, zurückgreifen. Er kann also das Verhaltens- und Präferenzprofil seiner Bestandskunden mit deren Social-Media-Informationen anreichern. Um die Reichweite für seine Neukundenkampagne zu erhöhen, versucht er Statistical Twins zu ermitteln.

In der Discovery Engine wählt er also die Use Case Lookalikes bzw. Statistical Twins aus und gibt als Datenquellen Behavioral und Social Data an. Die Discovery Engine trifft im Hintergrund die erforderlichen aufwendigen Datentransformationen und berechnet basierend auf Algorithmen Ähnlichkeitsmuster, die angeben, welche zusätzlichen Eigenschaften potenzielle Neukunden haben müssen, um als Zwillinge mit ähnlichem Profil wie die Bestandskunden zu gelten. Interessant dabei ist, ob sich die Kenntnis von Social-Media-Daten (Verhaltensprofile von Freunden und Bekannten des Users und deren Kaufhistorie) positiv auf die Qualität der Modellierung der Statistical Twins auswirkt. Folgende Fragen könnte die Discovery Engine für den ausgewählten Use Case beantworten:

Wie performt eine Prediction der statistischen Zwillinge:

- alleine auf Behavioral Data?

- alleine auf Social Media?

- basierend auf beiden kombinierten Datenquellen der angereicherten Profildaten?

Verbessert die Kombi Behavioral und Social die Reichweite, wenn wir unter den Freunden die Multiplikatoren finden, oder vergrößert sich die Reichweite signifikant, wenn wir die Freunde mit ähnlichem Kaufverhalten dazu nehmen und dazu noch deren Freunde?

Marketer oder Mediaplaner könnten aus diesen von der Discovery Engine vorgeschlagenen Szenarien und Ergebnissen die geeignete Vorgehensweise auswählen und per Knopfdruck oder automatisch die relevanten Marketingprozesse anstoßen. Dies ist nur ein Anwendungsszenario aus dem gesamten Leistungsspektrum von Discovery Engines.

Fazit

Bisher gibt es solche Discovery Engines noch nicht in Serienreife, aber sie könnten ein wichtiger Trigger für die Anwendung und den Erfolg von Smart Knowlegde sein. Discovery-Engines helfen Marketingverantwortlichen dabei, große Datenmengen und vielfältige Datenquellen in hoher Geschwindigkeit nachhaltig zu nutzen – die Datability sicherzustellen und aus den Daten zu lernen.

Über den Autor:

Andreas Volz ist seit 10 Jahren im Online-Marketing tätig. Volz greift auf seine langjährige Expertise in den Bereichen Datenanalyse, analytisches Consulting und datenbasierte Strategieentwicklung zurück. Er war mitverantwortlich für den Aufbau und Ausbau des Zielgruppen- und Analyseparts für das Targetingsystem TGP ® der 1und1 media factory und hat an der Konzeption und Evaluierung verschiedener Targetingsysteme und Kampagnenoptimierungslösungen mitgewirkt. Inzwischen ist er Inhaber der Firma datenstrategien in Lüneburg mit dem Schwerpunkt Data-Science-Anwendungen und war bis Oktober 2013 in verschiedenen Multichannel-Projekten bei der eValue Ventures AG beschäftigt. Im Dezember wird Andreas Volz zu dem Thema Smart Knowledge und Discovery Engines das E-Book „Data Curry – Der richtige Mix macht’s!“, veröffentlichen.

EVENT-TIPP ADZINE Live - SPOTLIGHT: Audio Innovation am 09. September 2025, 11:30 Uhr - 12:15 Uhr

In dieser SPOTLIGHT-Folge nehmen wir Innovationen im Audio-Bereich unter die Lupe. Jetzt anmelden!